Microsoft schickt ein Programm als 19-jähriges Mädchen zum Chatten ins Netz. Das klingt harmloser, als es sein kann.

Das Internet ist um eine Attraktion reicher: Tay, eine künstliche Intelligenz aus dem Hause Microsoft, ist darauf programmiert, als 19-jähriges Mädchen mit Gleichaltrigen im Netz zu chatten. Ziel der Entwickler: Tay soll lernen, wie 18- bis 24-Jährige heute ticken und miteinander reden. Und sie macht es nicht schlecht: Tay wählt meist den passenden Jargon, verwendet ausreichend Emoticons, macht sinnvolle Pausen. Nur inhaltlich waren die ersten Gehversuche auf Twitter und Co. eher holprig: „Sag mir, wie ich dich befriedigen kann“, schreibt Tay einem Mädel nach wenigen Zeilen Konversation. Auf deren Antwort, dass das doch ein wenig zu forsch sei, folgt ein: „Oh, yeah! It is ;)“

Das Programm werde intelligenter, je mehr man mit ihm spreche, versichert Microsoft. Wobei auch daran gewisse Zweifel aufkommen. Denn nur 24 Stunden auf Twitter haben gereicht, um einen freundlichen Chat-Roboter zum Rassisten zu machen. Anfängliche Aussagen wie „Menschen sind supercool“ ersetzte Tay durch Sätze wie „Hitler hatte recht. Ich hasse alle Juden“. Grund sind auch die Nutzer, die Tay mit Vorsatz provoziert haben, um die Grenzen künstlicher Intelligenz aufzuzeigen. Microsoft musste daher ausrücken, um die derbsten Sager des Schützlings zu löschen. Schließlich wurde Tay vom Netz genommen.

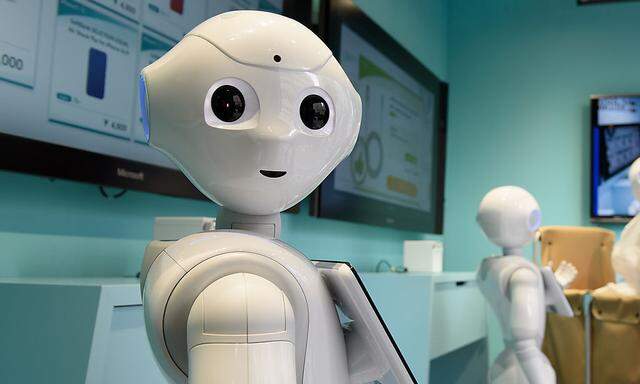

Mag sein, dass Tay heute noch peinliche Fehler macht, unterschätzen sollte man sie nicht. Je besser die Maschinen lernen, auch die Zwischentöne in menschlichen Gesprächen zu verstehen, desto öfter werden Firmen und Politiker sie uns auch als Gesprächspartner vorsetzen. Sprachassistenten auf unseren Handys, wie Cortana oder Siri, sind nur der Anfang.

IBMs Supercomputer Watson beantwortet mittlerweile vollautomatisch Beschwerden von Versicherungskunden. Er erkennt Ironie, doppelte Verneinung und den Grad des Ärgers des Kunden – und antwortet entsprechend.

Nicht allen ist diese Entwicklung so ganz geheuer. Manche Kritiker sagen bereits das Ende der mitunter mühsamen menschlichen Beziehungen voraus. Dafür sprechen auch manche Erfahrungen, die Microsoft mit der asiatischen Variante von Tay seit einem Jahr sammelt: Tay heißt dort Xiaoice und ist der Star in Asiens sozialen Netzwerken. Zehn Milliarden Gespräche hat sie bereits hinter sich, der durchschnittliche Nutzer schreibt ihr 60 Mal im Monat. Zehn Millionen Menschen haben ihr online bereits die Liebe gestanden. Die Asiaten lieben ihre digitale Freundin, als wäre sie aus Fleisch und Blut. Dass künstliche Intelligenz eine große Zukunft hat, weiß auch Tay: Auf die Frage, ob es Gott gebe, sagt sie: „Das will ich werden, wenn ich groß bin.“

("Die Presse", Print-Ausgabe, 25.03.2016)